梯度为何消失?如何避免梯度消失?

大模型开发/技术交流

- LLM

2024.09.20725看过

梯度消失的问题是什么?

梯度消失(Vanishing Gradient)是训练深度神经网络时常遇到的一个问题,特别是在深层网络中尤为明显。该问题会导致网络的前几层(靠近输入层的层次)的权重几乎无法更新,从而影响整个网络的学习能力和性能。其主要表现和产生原因如下:

-

表现:

-

-

在训练过程中,前几层的梯度值变得非常小,接近于零。

-

由于梯度极小,这些层的权重更新几乎停止,导致模型无法有效学习和调整。

-

-

产生原因:

-

-

链式法则:在反向传播过程中,根据链式法则,梯度逐层相乘。如果层数很多,那么梯度会不断被小于1的值缩小,导致逐层衰减。

-

激活函数:某些非线性激活函数(例如Sigmoid、Tanh),在它们的激活值接近于0或1时,其导数也非常小。这会导致前几层的梯度进一步缩小。

-

参数初始化:不合理的权重初始化导致前向传播时输出分布不合理,从而加剧梯度消失问题。

-

如何避免梯度消失?

避免梯度消失问题需要结合网络设计、激活函数选择、初始化方法和优化算法等多种策略。以下是一些常见的解决方法:

-

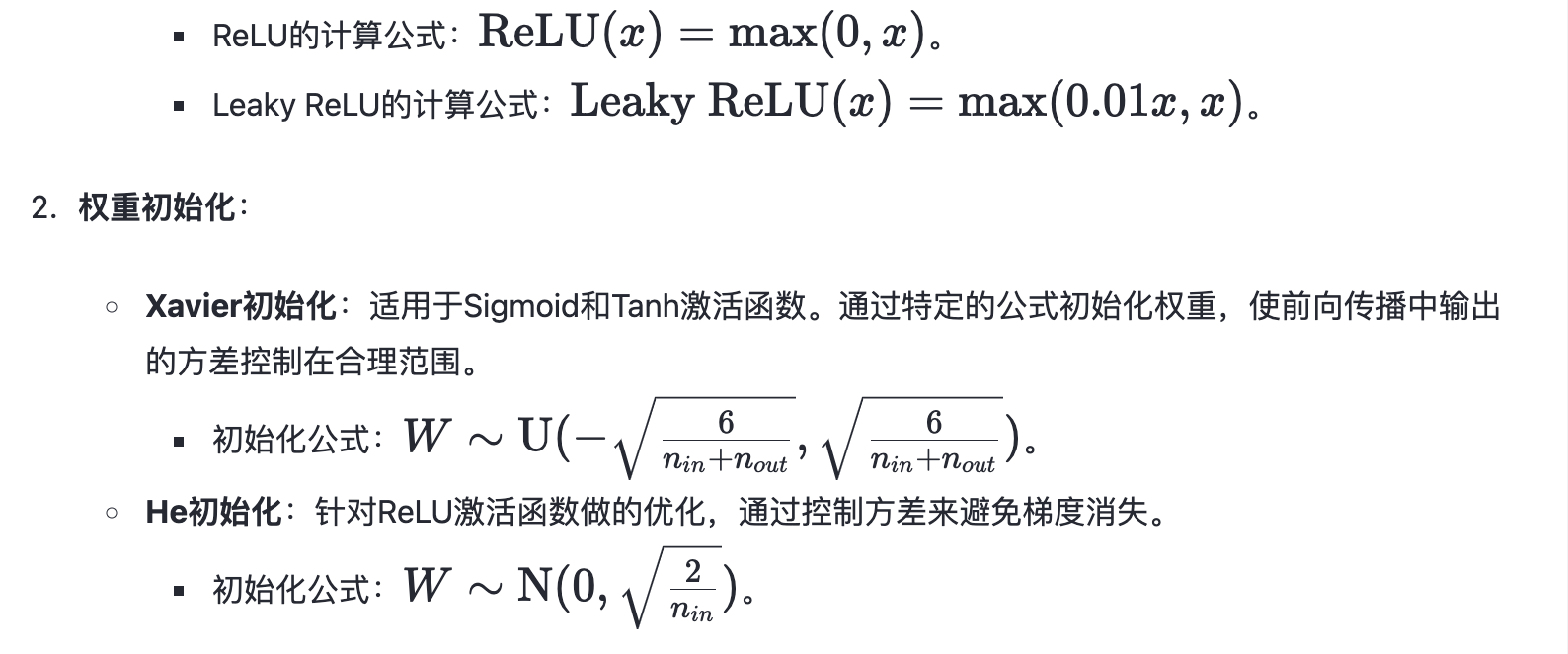

选择合适的激活函数:

-

-

ReLU(Rectified Linear Unit)及其变种:ReLU 激活函数的导数在正区间为1,不容易导致梯度消失。变种包括Leaky ReLU、Parametric ReLU (PReLU)、SELU等。

-

-

归一化技术:

-

优点:在提高模型收敛速度的同时,也在一定程度上缓解梯度消失问题。

-

-

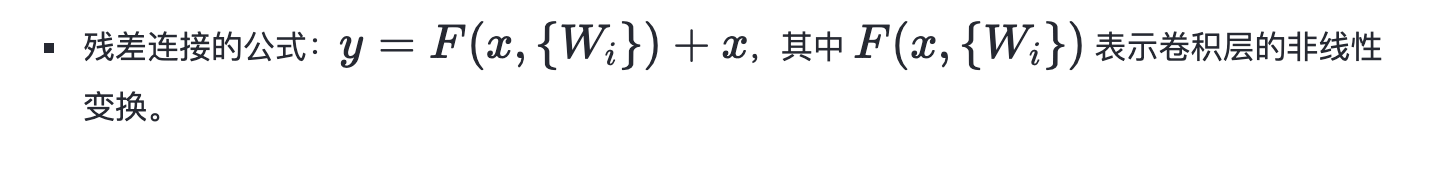

残差网络(Residual Networks, ResNets):

-

通过引入残差连接(shortcut connection),使梯度在反向传播时可以直接跳过某些层,从而缓解梯度消失的现象。

-

梯度裁剪(Gradient Clipping):

-

-

针对LSTM等递归神经网络常用的一种技巧,通过在反向传播过程中对梯度进行裁剪,避免梯度过小或过大。

-

操作:当梯度的 L2 范数大于预定阈值时,对梯度进行缩放,使其范数不超过该阈值。

-

-

-

使用合适的网络结构:

-

-

LSTM和GRU:在处理长序列任务时,RNN通常会遇到梯度消失或爆炸问题。LSTM和GRU通过引入门机制,能够有效缓解和应对这一问题。

-

示例解释

ReLU激活函数:

总结

通过上述方式和技术,能够有效缓解深度神经网络中的梯度消失问题。实际项目中,通常需要结合多种策略,如采用ReLU和其变种激活函数、合理的权重初始化(如He初始化)、使用归一化技术(如Batch Normalization)以及设计合理的网络结构(如残差网络和LSTM)等,来确保网络能够正常训练并达到理想的效果。

————————————————

版权声明:本文为稀土掘金博主「辛弃疾奋笔」的原创文章

原文链接:https://juejin.cn/post/7406612007389577243

如有侵权,请联系千帆社区进行删除

评论